Bilim insanları açıkladı: Yapay zeka mantıksız ve hata yapmaya eğilimli

Bilim insanları, yapay zekanın insanlardan çok daha mantıksız olabileceğini ortaya çıkardı. Yedi farklı yapay zeka modeline insan muhakemesini test etmek için tasarlanmış sorular soruldu. Çoğu model, soruların yarısından fazlasına yanlış yanıt verdi. En iyi performansı gösteren yapay zeka, yüzde 69,2 oranında doğru ve insani mantıkla yanıt veren “ChatGPT 4-0” oldu.

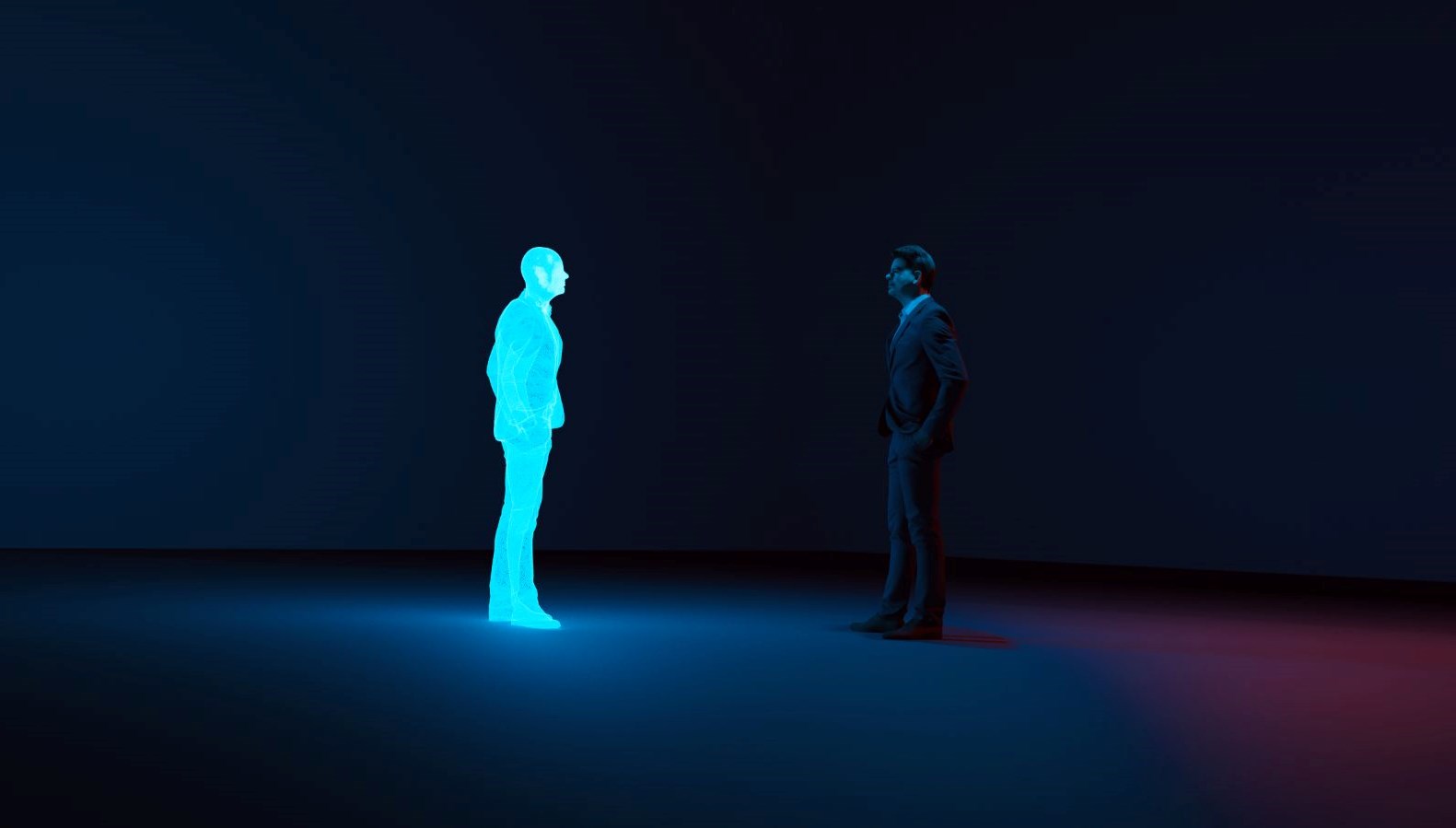

Yapay zeka soğuk ve mantıksal akıl yürütmenin somut bir örneği olarak değerlendirilse de araştırmacılar onların insanlardan çok daha mantıksız olabileceğini öne sürüyor.

University College London’dan araştırmacılar, en iyi yedi yapay zeka aracını insan muhakemesini test etmek için tasarlanmış bir dizi klasik teste tabi tuttu.

En iyi performans gösteren yapay zekaların bile mantıksız olduğu ve basit hatalara yatkın olduğu görüldü. Çoğu model, soruların yarısından çoğunda yanlış yanıt verdi.

Araştırmacılar, bu modellerin insanlarla aynı şekilde mantıksız olmadığını, hatta bazılarının mantık sorularını “etik gerekçelerle” yanıtlamayı reddettiğini ortaya çıkardı.

Araştırma yazarı Olivia Macmillan-Scott, “Çalışmamızın sonuçlarına ve yapay zeka araçları üzerine yapılan diğer araştırmalara dayanarak, bu modellerin henüz insanlar gibi ‘düşünmediğini’ rahatlıkla söyleyebiliriz” diye konuştu.

7 FARKLI YAPAY ZEKA MODELİ TEST EDİLDİ

Araştırmacılar, OpenAI’nin ChatGPT’si, Meta’nın Llama’sı, Claude 2 ve Google Gemini’ın çeşitli versiyonları dahil olmak üzere yedi farklı yapay zeka modelini test etti.

Modellerden tekrar tekrar, insanların muhakeme yeteneklerini test etmek için tasarlanan 12 klasik mantık sorusuna yanıt vermeleri istendi.

İnsanlar da genellikle bu tür testlerde kötüdür ancak yapay zekalar “insan benzeri” olsaydı, aynı tür önyargılar nedeniyle karar alacaktı.

Ancak araştırmacılar yapay zekanın tepkilerinin çoğunlukla ne rasyonel ne de insana benzer olduğunu ortaya çıkardı.

DOĞRU MANTIK, YANLIŞ CEVAP

Bir soruda, Meta’nın Llama modeli sürekli olarak sesli harfleri ünsüz harflerle karıştırdı. Bu da onun, mantığı doğru olsa bile yanlış cevap vermesine yol açtı.

Yapay zeka sohbet robotlarından bazıları, soruların tamamen masum olmasına rağmen etik gerekçelerle birçok soruya yanıt vermeyi de reddetti.

Araştırmacılar bunun muhtemelen koruma özelliklerinin yanlış çalışması ve aşırı dikkatli olmayı seçmesinden kaynaklandığını öne sürüyor.

EN TUTARLI YANITLARI CHATGPT VERDİ

Ayrıca yapay zekaların farklı yönlendirmeler arasında tutarsız olması nedeniyle mantıksız olduğu sonucuna varıldı. Aynı model, aynı soruya farklı ve sıklıkla çelişkili yanıtlar sunabiliyor.

12 sorunun tamamında en iyi performansı gösteren yapay zeka, yüzde 69,2 oranında doğru ve insani mantıkla yanıt veren ChatGPT 4-0 oldu.

En kötü performans gösteren model, soruların yüzde 77,5’inde yanlış cevap veren Meta’nın Llama 2 7b modeliydi.